LeNet-5 笔记

1. LeNet-5网络

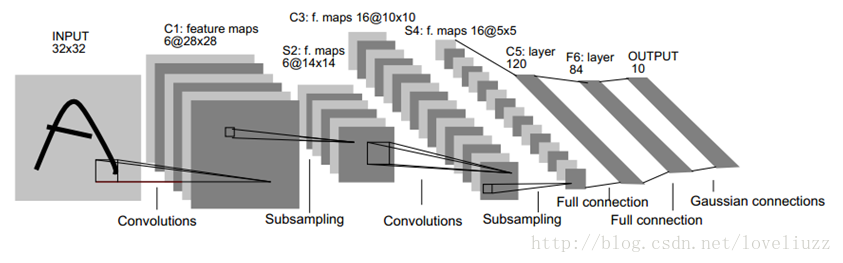

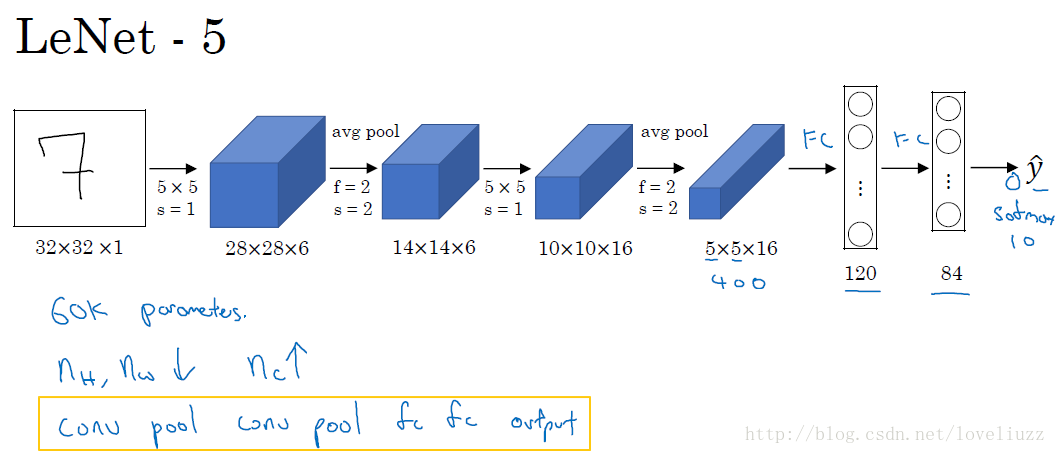

LeNet-5网络是针对灰度图进行训练的,输入图像大小为32*32*1, 不包含输入层的情况下共有7层,每层都包含可训练参数(连接权重)。

- 输入尺寸:32*32;

- 卷积层:2个;

- 降采样层(池化层):2个;

- 全连接层:2个;

- 输出层:1个。10个类别(数字0-9的概率);

1. C1层是一个卷积层(通过卷积运算,可以使原信号特征增强,并且降低噪音)

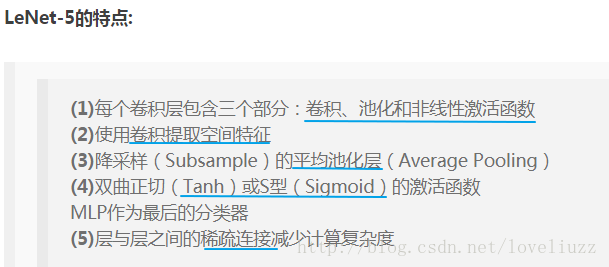

第一层使用5*5大小的过滤器6个,步长s = 1,padding = 0。即:由6个特征图Feature Map构成,特征图中每个神经元与输入中5*5的邻域相连,输出得到的特征图大小为28*28*6。C1有156个可训练参数(每个滤波器5*5=25个unit参数和一个bias参数,一共6个滤波器,共(5*5+1)*6=156个参数),共156(2828)=122,304个连接。

2. S2层是一个下采样层(平均池化层)(利用图像局部相关性的原理,对图像进行子抽样,可以减少数据处理量同时保留有用信息,降低网络训练参数及模型的过拟合程度)。

第二层使用2*2大小的过滤器,步长s = 2,padding = 0。即:特征图中的每个单元与C1中相对应特征图的2*2邻域相连接,有6个14*14的特征图,输出得到的特征图大小为14*14*6。池化层只有一组超参数 f 和 s,没有需要学习的参数。

3. C3层是一个卷积层

第三层使用5*5大小的过滤器16个,步长s = 1,padding = 0。即:由16个特征图Feature Map构成,特征图中每个神经元与输入中5*5的邻域相连,输出得到的特征图大小为10*10*16。C3有416个可训练参数(每个滤波器5*5=25个unit参数和一个bias参数,一共16个滤波器,共(5*5+1)*16=416个参数)。

4. S4层是一个下采样层(平均池化层)

第四层使用2*2大小的过滤器,步长s = 2,padding = 0。即:特征图中的每个单元与C3中相对应特征图的2*2 邻域相连接,有16个5*5的特征图,输出得到的特征图大小为5*5*16。没有需要学习的参数。

5. F5层是一个全连接层

有120个单元。每个单元与S4层的全部400个单元之间进行全连接。F5层有120*(400+1)=48120个可训练参数。 如同经典神经网络,F5层计算输入向量和权重向量之间的点积,再加上一个偏置。

6. F6层是一个全连接层

有84个单元。每个单元与F5层的全部120个单元之间进行全连接。F6层有84*(120+1)=10164个可训练参数。 如同经典神经网络,F6层计算输入向量和权重向量之间的点积,再加上一个偏置。

7. Output输出层

输出层由欧式径向基函数(Euclidean Radial Basis Function)单元组成,每类一个单元,每个有84个输入。 换句话说,每个输出RBF单元计算输入向量和参数向量之间的欧式距离。输入离参数向量越远,RBF输出的越大。 用概率术语来说,RBF输出可以被理解为F6层配置空间的高斯分布的负log-likelihood。 给定一个输式,损失函数应能使得F6的配置与RBF参数向量(即模式的期望分类)足够接近。

2. 总结

随着网络越来越深,图像的宽度和高度都在缩小,信道数量一直在增加。目前,一个或多个卷积层后边跟一个. 池化层,再接上一个全连接层的排列方式很常用。

| Layer | Activation Shape | Activation Size | parameters |

|---|---|---|---|

| Input | (32, 32, 1) | 1024 | 0 |

| CONV1(f=5, s=1) | (28, 28, 6) | 4704 | (5*5+1)*6=156 |

| POOL1 | (14, 14, 6) | 1176 | 0 |

| CONV2(f=5, s=1) | (10, 10, 16) | 1600 | (5*5*6+1)*16=2416 |

| POOL2 | (5, 5, 16) | 400 | 0 |

| FC3 | (120, 1) | 120 | 120*(400+1)=48120 |

| FC4 | (84, 1) | 84 | 84*(120+1)=10164 |

| Softmax | (10, 1) | 10 | 10*(84+1)=850 |